您是否正在寻找一些值得实施的SEO黑客?

好吧,那么您来对地方了。

计划充分利用SEO的任何人都将一直在不断寻找一些快速且无害的骇客。

我们也不例外。

我们喜欢寻找使我们的生活更加简单和美好的新方法。

今天,我们在这里为您提供一种技术,这也是我们绝对喜欢的技术之一。

这是最合法的SEO黑客之一,您无需等待就可以立即开始。

这是 通过利用网站最自然的方面之一来极大地提高SEO努力成果的一种方法 。

已经在猜测这部分可能是什么?

好吧,给你一个提示,这是一个很少被谈论的方面,当然也不难实现。

得到它了?

是的,这是您的robots.txt文件。也称为机器人排除标准或协议。

这个特殊的微小文本文件是万维网上任何网站的重要组成部分,大多数人甚至都不认识。

现在,使此元素与搜索引擎一起使用。

但是,令人惊讶的事实是,它是SEO的重要组成部分,它正在等待您使用它。

我们已经看到了超过客户的客户,他们正在尽一切可能使他们的SEO努力发挥作用。

因此,当我们说可以通过对其小的文本文件进行一些更改来做很多事情时,他们很难相信。

尽管有许多 非常简单且耗时较少的SEO策略,但如果我们说这是最简单的方法,那我们就不会错。

最好的部分是,您不需要任何技术专长即可充分利用robots.txt所提供的功能。

如果您能够找到网站的源代码,那么您都可以使用此技巧。

一旦准备就绪,就跟着我们。

我们将清楚地向您展示如何对robots.txt文件进行修改,以使搜索引擎最终喜欢它。

是什么使Robots.txt文件如此重要?

在获得此问题的答案之前,对您来说,了解robots.txt为何如此重要至关重要。

也称为漫游器排除标准或协议,robots.txt文件不过是文本文件,可以帮助网络漫游器(主要是搜索引擎)选择要爬网的正确页面。

话虽如此,它还告诉这些机器人这些不应爬网的页面。

让我们假设一个特定的搜索引擎将要访问一个特定的网站。

现在,在搜寻目标网页之前,它会检查robots.txt以获取所需的说明。

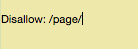

有各种robots.txt文件。现在让我们看一下其中一些不同的类型,并了解它们的外观。

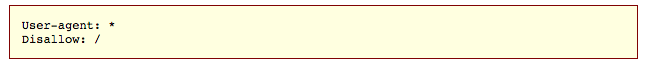

让我们假设,搜索引擎最终找到以下robots.txt文件类型:

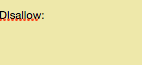

现在,这是任何robots.txt文件的标准基本结构。

在上图中,出现在短语“用户代理”之后的星号表示此robots.txt文件适用于访问该特定站点的所有Web机器人。

最重要的是,您所有SEO策略的目的都是轻松让搜索引擎抓取您的网站,从而提高您的排名。

这正是此SEO黑客的秘密所在。

您的网站上可能有多个页面,对吗?

如果您不同意我们,请返回并自己检查。我们相信您会感到惊讶。

当搜索引擎在您的网站上爬行时,它们将在您网站上的每个页面上爬行。

如果您有多个页面,那么搜索引擎机器人将花费相当多的时间来爬网所有页面。

时间流逝可能会对您的网页排名产生负面影响。

好吧,这是因为Google搜索引擎机器人有一种称为“抓取预算”的东西。

这可以分为两部分:

1.抓取速率限制

2.抓取需求

抓取速率限制

Googlebot的主要优先事项是抓取,同时确保用户访问您的网站时不会降低用户体验。

这称为“爬网速率限制”。

该因素限制了任何给定站点的最大可能获取速率。

换句话说,它是Googlebot用来在网站上进行爬网的并行连接总数,以及两次获取之间的等待时间。

抓取需求

让我们假设尚未达到爬网速率限制。您认为Googlebot会非常活跃吗?

不,直到有索引需求为止。

这称为爬网需求。

好了,回到这一点,抓取预算是Googlebot想要抓取并可以抓取的网页数量。

那么,有没有猜到您的目标是什么?

是的,您知道了。您应确保Googlebot合理地将抓取预算用于您的网站。

简而言之,Googlebot应该抓取您所有最有价值的网页。

根据Google的说法,现在有某些因素可能会对网站的爬网和索引产生负面影响。

这些因素也称为低价值网址,可以分为以下几种:

3.软错误页面

4.质量低下和/或垃圾内容

5.被入侵的网页

6.现场重复内容

7.代理和无限空间

8.会话标识符和多面导航

如果您在此类页面上浪费服务器资源,则会减少实际上有价值的页面上的爬网活动。

反过来,这将极大地延迟在您的网站上发现优质内容的过程。

返回到robots.txt。。。。

通过创建适当的robots.txt页面,您将能够引导搜索引擎机器人并阻止它们在低质量的页面上抓取。

只是看看其中的含义。

当您成功引导搜索引擎机器人仅对您网站上最有用的内容进行爬网时,将仅根据该内容对您的网站进行爬网和建立索引。

基本上,您将通过在网站上不重要的页面上进行爬网来防止爬网程序浪费爬网预算。

因此,通过正确使用robot.txt,您将能够告诉搜索引擎机器人明智地花费其抓取预算。

这就是使robots.txt文件在SEO上下文中如此重要的原因。

对robots.txt的功能感到惊讶吗?

好吧,你应该。这就是它的力量。

现在,让我们了解如何识别和使用它。

找到您的Robots.txt文件

如果您想快速查看robots.txt文件,那么我们为您提供了一种非常简单的方法。

实际上,我们将要揭示的方法可以适用于任何网站。

因此,您可以仅浏览其他网站的文件,也可以知道它们的作用。

您要做的只是在网站的搜索栏中键入所需网站的基本URL,然后在末尾添加robots.txt。

将出现以下三种情况之一:

1.您会找到您的robots.txt文件

2.你会发现一个空文件

3.您将看到404错误消息

现在花点时间查看您自己网站的robots.txt文件。

如果您收到404错误消息或找到一个空文件,则意味着您必须对此进行修复。

但是,如果找到有效文件,则大多数情况下会将其设置为默认设置,该默认设置是在创建站点时进行的。

该方法对于查看其他网站的robots.txt文件特别有用。

一旦您完全了解了robots.txt,这将是一个不错的练习。

现在,让我们着手更改您的robots.txt文件。

修改文件

此步骤很大程度上取决于您是否具有robots.txt文件。

您可以通过执行上述方法找到相同的内容。

坏消息是,如果您没有此文件,则必须创建一个。

打开记事本或任何其他纯文本编辑器,再次确保您选择了纯文本编辑器。

这是因为使用Microsoft Word之类的程序会带来在文本中插入其他代码的威胁。

最好的免费选择之一是 editpad.org。另外,在本文中,我们将使用它。

返回robots.txt。

如果您已经有了robots.txt文件,则只需在网站的根目录中找到它即可。

好吧,如果您不太习惯浏览源代码,那么很可能会发现很难找到robots.txt文件的可编辑版本。

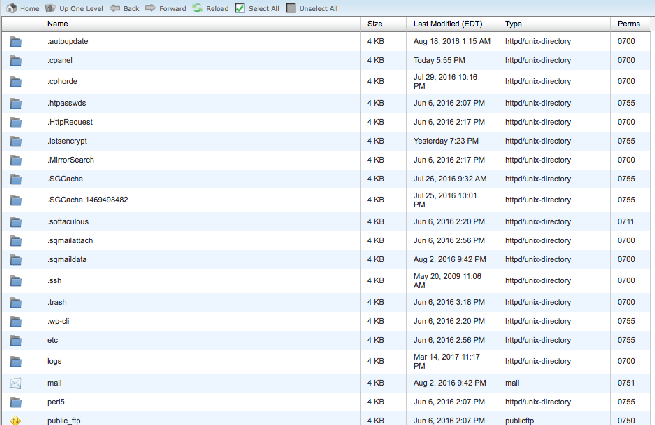

通常,您只需访问托管帐户网站即可找到根目录。

在这里,您应该先登录,然后再进入FTP或网站的文件管理部分。

完成这些步骤后,您应该能够看到以下内容或类似内容:

在此,确定您的robots.txt文件,然后将其打开以进行修改。删除所有文本,但不要删除文件。

注意:如果您使用的是WordPress,则一旦访问robots.txt / yoursite.com,便可以看到robots.txt文件,但在文件中找不到它。

这主要是因为当您的根目录中没有robots.txt文件时,WordPress倾向于创建虚拟robots.txt文件。

这件事也发生在你身上吗?

好吧,在这种情况下,您将必须制作robots.txt文件。

Robots.txt文件创建

您可以借助自己喜欢的纯文本编辑器轻松地创建新的robots.txt文件。

只要确保您使用的是纯文本编辑器即可。

但是,如果您已经有一个robots.txt文件,则只需确保已删除所有文本而不删除该文件即可。

首先,您首先应该熟悉robots.txt文件中使用的语法。

Google为 robot.txt的一些基本术语提供了很好的解释。

现在,我们将详细说明如何设置robots.txt文件。

完成此操作后,我们将研究如何自定义它以获得更好的SEO。

准备好了吗?

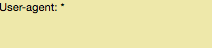

好的,让我们从设置用户代理条款开始。

您应该对其进行设置,使其适用于所有网络机器人。

这可以通过在用户代理短语的末尾添加“星号”来完成。请参考下图:

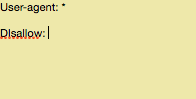

接下来,您将必须输入“ Disallow”,但是请稍等。。。之后,请确保您没有输入任何内容,如下图所示:

如果在“禁止”一词之后没有任何内容,您将指示网络机器人爬网您的整个网站。

此时,您网站上的所有内容都将是公平的游戏。

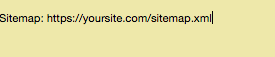

如果您已按照这些步骤操作,则robots.txt文件应如下所示:

我们知道,这看起来非常简单,但是这两行已经做了很多工作。

虽然您也可以链接 XML网站地图,但这不是必需的。但是,如果您希望包含它,则可以使用以下格式:

现在,这就是基本的robots.txt文件的外观。

现在,您应该将这个简单的文件转换为主要的SEO增强器,从而将其提升到一个新的水平。

针对SEO优化Robots.txt文件

您应该对robots.txt文件进行的优化类型很大程度上取决于您网站上的内容类型。

有很多方法可以利用robots.txt文件来发挥自己的优势。

我们将探讨一些利用它的常见方法。

注意:使用这些文件阻止来自搜索引擎的页面是不合适的。这是一个很大的问题。

这些文件的主要用途之一是通过引导文件并防止它们对用户可见的网站部分进行爬网,从而最大化搜索引擎的爬网预算。

例如,只需尝试访问任何网站的robots.txt文件。

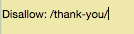

您将意识到,大多数站点都将不允许其登录页面。

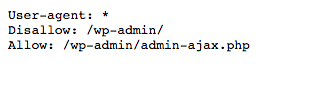

请参考下图:

这是因为登录页面仅用于登录到任何给定网站的后端。

因此,让搜索引擎机器人在此类页面上爬行毫无意义。

这样,您可以使用类似的命令来禁止某些网页并阻止搜索引擎机器人在它们上爬行。

一旦编写了禁止命令,请在2个正斜杠之间添加该页面的URL部分(仅在“ .com”之前存在的部分)。

请参考下图:

您现在是否想知道应从索引中排除哪些类型的页面?

好吧,这是一个好问题。

以下是一些最常见的页面,可以将其排除在索引之外。

故意重复内容

尽管重复的内容是不被接受的,但是在某些情况下,这些类型的内容是必需的并且也被接受。

假设您已经为特定页面创建了易于打印的版本。

在这种情况下,从技术上讲,您将拥有重复的内容。

因此,在这种情况下,您可以引导搜索引擎机器人,并阻止他们抓取网页的易于打印的版本。

这也有助于拆分内容相同但设计不同的测试页。

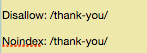

谢谢页面

我们知道我们知道。。。作为营销人员的“谢谢”页面将是您最喜欢的页面之一,因为该页面为您提供了一些新的潜在客户。

是不是

但是,众所周知的事实是,Google可以轻松访问某些“谢谢”页面。

因此,这是一个坏消息,因为这意味着用户无需进行潜在顾客捕获过程即可访问此类页面。

好吧,好消息是,您可以通过阻止“谢谢”页面来确保只有合格的潜在顾客才能看到这些页面。

因此,如果在特定URL(https://yoursite.com/thank-you/)上找到“谢谢”页面,则在robots.txt文件中阻止此页面的过程将如下所示:

由于没有专门禁止这些页面的通用规则,因此您可以放心,此文件对于您的网站是唯一的。

因此,您可以在这里进行判断。

但是,您应该知道另外两个指令,它们是:

- Nofollow

- 无索引

到目前为止,您已经非常了解我们一直在使用的“ disallow”指令。

事实是,它根本不会阻止您的网页编制索引。

那么这是什么意思?

这仅意味着即使您禁止特定页面,也无法完全阻止它结束在索引中。

那是你不想要的。

这正是您的no index指令可以拯救您的地方。

它与disallow指令协同工作,以确保搜索引擎机器人不会索引或访问某些页面。

对特定页面执行此操作后,可以确保该页面不会出现在搜索引擎结果页面中。

但是,仅由于nofollow指令不是robots.txt文件的一部分,所以其实现方式会稍有不同。

但是,nofollow指令继续指导网络机器人,因此概念保持不变,唯一的区别是发生的位置。

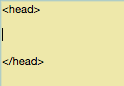

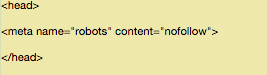

因此,只需确定要修改的源代码,并确保您位于标签“ <head>”之间。

现在,在此之后,只需粘贴以下行:

“ <元名称=”机器人” content =“ nofollow”>”

完成后,它应如下所示:

您必须确保此处的一件事是您没有将此行放置在任何其他标签之间。

对于感谢页面,这也是一个不错的选择,因为网络机器人不会抓取指向专有内容的链接,例如铅磁铁,

但是,如果您想同时添加nofollow和noindex指令,请使用以下代码:

<元名称=“机器人” content =“ noindex,nofollow”>

这样做将为网络机器人提供两个指令。

测试一切

最后,不要忘记测试刚刚创建的robots.txt文件。这可以帮助您确保所有内容都有效并且以正确的方式工作。

Google提供了免费的robots.txt测试器,它是网站站长工具的一部分。

您只需注册您的网站管理员帐户,选择媒体资源,然后点击抓取即可。

然后,您将查看“ robots.txt测试器”,选择此选项。

如果框中已经有一些代码,请确保将其删除,然后将其替换为robots.txt文件。

接下来,选择选项“测试”。如果得到“允许”,则表示您的文件有效。

然后,您可以将robots.txt文件上传到根目录。

现在,您手中有一个功能强大的文件,这将有助于您提高可见性。

加起来

我们喜欢分享 我们所知道的所有小型 SEO骇客,这可以在许多方面为您带来巨大的优势。

通过这样做,您不仅在帮助自己,还在帮助您的访客。

当您帮助漫游器明智地将预算用于爬网时,它们将以最佳方式在搜索引擎结果页面中显示您的页面。

这仅意味着您可以获得更好的可见性。

此外,它是一次性设置,您仍然可以继续进行,并不时进行小更改,而不会遇到任何麻烦。

无论您是在第一个网站还是第十个 网站上进行操作,此技巧都将对您的SEO产生很大的影响。

让我们知道您的想法?

现在您已经掌握了全新的SEO策略,请尝试让我们知道我们的帖子有多有用。

如有疑问和反馈,请随时将其放在下面的评论部分。

--- END ---